Inteligenta artificiala este aici! Este exagerata, prost inteleasa si defectuoasa, dar este deja in centrul vietii noastre si nu va face decat sa isi extinda sfera de actiune.

Inteligenta artificiala alimenteaza cercetarea in domeniul masinilor fara sofer, detecteaza semne de boala altfel invizibile pe imaginile medicale, gaseste un raspuns atunci cand ii pui o intrebare (precum ChatGPT de la OpenAI) si iti permite sa iti deblochezi telefonul cu ajutorul fetei pentru a vorbi cu prietenii sub forma unui caca animat pe iPhone X, folosind Animoji de la Apple. Cu ajutorul AI poti chiar invata limba engleza, sau chiar face bani online.

Acestea sunt doar cateva dintre modurile in care AI ne atinge deja vietile, si mai sunt multe de facut. Dar nu va faceti griji, algoritmii superinteligenti nu sunt pe cale sa ia toate locurile de munca sau sa elimine umanitatea.

Actualul boom al inteligentei artificiale a fost catalizat de descoperirile facute intr-un domeniu cunoscut sub numele de invatare automata. Aceasta implica "antrenarea" computerelor pentru a indeplini anumite sarcini pe baza unor exemple, mai degraba decat sa se bazeze pe programarea de catre un om. O tehnica numita invatare profunda a facut ca aceasta abordare sa fie mult mai puternica. Intrebati-l pe Lee Sedol, detinatorul a 18 titluri internationale la jocul complex de Go. El a fost invins de un software numit AlphaGo in 2016.

Exista dovezi ca inteligenta artificiala ne poate face mai fericiti si mai sanatosi iar unele afaceri pot abuza - de exemplu: scrierea de articole de blog si/sau descrieri de produse. Dar exista si motive de precautie. Incidentele in care algoritmii au detectat sau au amplificat prejudecatile sociale legate de rasa sau de gen arata ca un viitor imbunatatit de inteligenta artificiala nu va fi automat unul mai bun.

Totul despre inteligenta artificiala (AI sau IA):

Inceputurile inteligentei artificiale

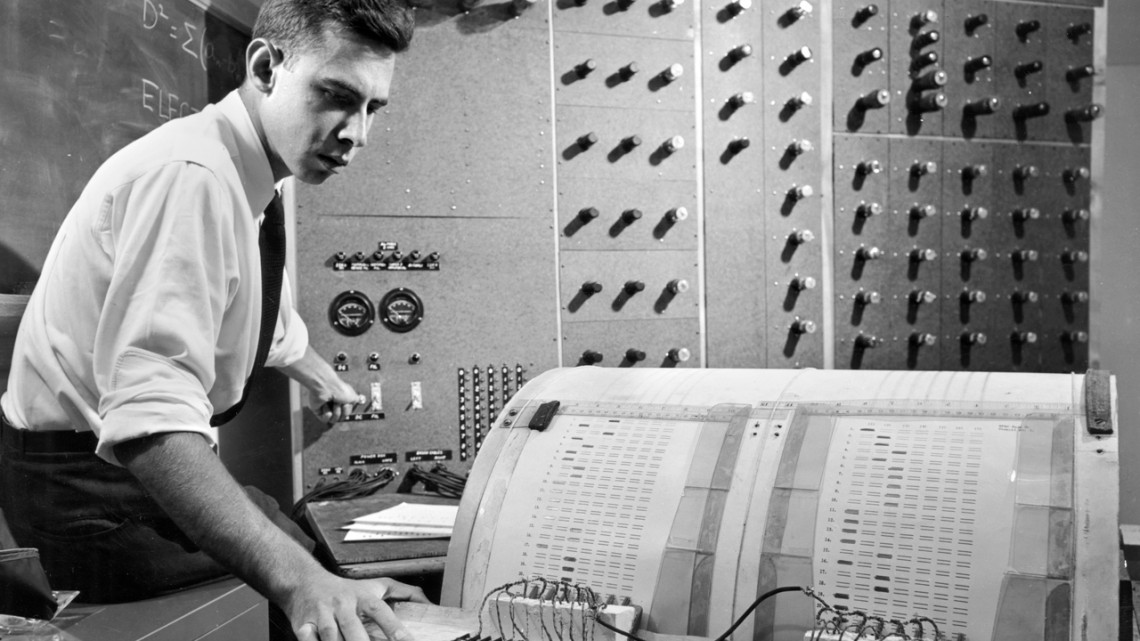

Inteligenta artificiala, asa cum o cunoastem noi, a inceput ca un proiect de vacanta. Profesorul John McCarthy, de la Dartmouth, a inventat termenul in vara anului 1956, cand a invitat un mic grup de oameni sa petreaca cateva saptamani gandindu-se cum sa faca masinile sa faca lucruri precum utilizarea limbajului.

Avea mari sperante de a realiza un progres in incercarea de a obtine calculatoare la nivelul uman de inteligenta. "Credem ca se poate face un progres semnificativ daca un grup de oameni de stiinta atent selectionati lucreaza impreuna la acest lucru timp de o vara", a scris John McCarthy impreuna cu coorganizatorii sai.

Aceste sperante nu au fost indeplinite, iar McCarthy a recunoscut ulterior ca a fost prea optimist. Dar atelierul i-a ajutat pe cercetatorii care visau la masini inteligente sa se concentreze intr-un domeniu academic recunoscut.

Primele lucrari se concentrau adesea pe rezolvarea unor probleme destul de abstracte de matematica si logica. Dar nu a trecut mult timp pana cand IA a inceput sa arate rezultate promitatoare in sarcini mai mult umane.

La sfarsitul anilor 1950, Arthur Samuel a creat programe care au invatat sa joace dame. In 1962, unul dintre ele a obtinut o victorie in fata unui maestru in acest joc. In 1967, un program numit Dendral a demonstrat ca poate reproduce modul in care chimistii interpretau datele de spectrometrie de masa privind compozitia probelor chimice.

Pe masura ce domeniul inteligentei artificiale s-a dezvoltat, au aparut si diferite strategii pentru a crea masini/computere mai inteligente. Unii cercetatori au incercat sa distileze cunostintele umane in cod sau sa elaboreze reguli pentru sarcini specifice, cum ar fi intelegerea limbajului. Altii au fost inspirati de importanta invatarii pentru a intelege inteligenta umana si animala.

Acestia au construit sisteme care ar putea deveni mai bune la o sarcina in timp, poate prin simularea evolutiei sau prin invatarea din date exemplificative. Acest domeniu a atins etapa dupa etapa, pe masura ce computerele stapaneau sarcini care inainte puteau fi indeplinite doar de oameni.

Invatarea profunda, combustibilul pentru actualul boom al inteligentei artificiale, reprezinta o renastere a uneia dintre cele mai vechi idei din domeniul inteligentei artificiale. Tehnica presupune trecerea datelor prin retele matematice inspirate in mare masura de functionarea celulelor cerebrale, cunoscute sub numele de retele neuronale artificiale. Pe masura ce o retea proceseaza datele de instruire, conexiunile dintre partile retelei se ajusteaza, dezvoltand capacitatea de a interpreta datele viitoare.

Retelele neuronale artificiale au devenit o idee consacrata in inteligenta artificiala la scurt timp dupa atelierul de la Dartmouth. De exemplu, Perceptron Mark 1 din 1958, care umplea o camera, a invatat sa distinga diferite forme geometrice si a fost prezentat in The New York Times drept "Embrion al unui computer proiectat sa citeasca si sa devina mai intelept". Dar retelele neuronale au cazut in dizgratie dupa ce o carte influenta din 1969, scrisa in colaborare cu Marvin Minsky de la MIT, a sugerat ca acestea nu pot fi foarte puternice.

Cu toate acestea, nu toata lumea a fost convinsa de sceptici, iar unii cercetatori au mentinut tehnica in viata de-a lungul deceniilor. Acestia au fost indreptatiti in 2012, cand o serie de experimente au aratat ca retelele neuronale alimentate cu volume mari de date ar putea conferi masinilor noi puteri de perceptie (ceea ce numim "antrenare AI"). Tratarea unui numar atat de mare de date era dificila cu ajutorul cipurilor de calculator traditionale, dar trecerea la placile grafice/video moderne (GPU) a precipitat o explozie a puterii de procesare.

Intr-un rezultat notabil, cercetatorii de la Universitatea din Toronto si-au invins rivalii intr-o competitie anuala in care software-ul este insarcinat cu clasificarea imaginilor. Intr-un alt caz, cercetatorii de la IBM, Microsoft si Google au facut echipa pentru a publica rezultate care arata ca invatarea profunda ar putea, de asemenea, sa aduca un salt semnificativ in ceea ce priveste acuratetea recunoasterii vorbirii.

Companiile de tehnologie au inceput sa angajeze cu frenezie toti expertii in invatare profunda (deep learning) pe care ii puteau gasi. Cu toate acestea, este important de retinut ca domeniul inteligentei artificiale a avut mai multe boom-uri si crize (cunoscute si ca "ierni ale inteligentei artificiale") in trecut, iar o schimbare radicala ramane o posibilitate si in prezent.

Momente care au modelat IA

- 1956 Proiectul de cercetare de vara de la Dartmouth privind inteligenta artificiala da numele unui nou domeniu preocupat sa faca software-ul inteligent ca oamenii.

- 1965 Joseph Weizenbaum de la MIT creeaza Eliza, primul chatbot, care se da drept psihoterapeut.

- 1975 Meta-Dendral, un program dezvoltat la Stanford pentru interpretarea analizelor chimice, face primele descoperiri facute de un computer care au fost publicate intr-o revista cu referenti.

- 1987 O furgoneta Mercedes echipata cu doua camere de luat vederi si o gramada de computere se conduce singura 20 de kilometri pe o autostrada din Germania, la peste 55 km/h, in cadrul unui proiect academic condus de inginerul Ernst Dickmanns.

- 1997 Calculatorul Deep Blue al IBM il invinge pe campionul mondial de sah Garry Kasparov.

- 2004 Pentagonul organizeaza Darpa Grand Challenge, o cursa de masini robotizate in desertul Mojave, care catalizeaza industria masinilor autonome.

- 2012 Cercetatorii dintr-un domeniu de nisa numit "deep learning" (invatare profunda) stimuleaza un nou interes al intreprinderilor pentru inteligenta artificiala, demonstrand ca ideile lor pot face recunoasterea vorbirii si a imaginilor mult mai precisa.

- 2016 AlphaGo, creat de unitatea Google DeepMind, invinge un campion mondial la jocul de societate Go.

Starea actuala a inteligentei artificiale

Imbunatatirile aduse la hardware-ul de inteligenta artificiala, cresterea numarului de cursuri de formare in domeniul invatarii automate si proiectele de invatare automata cu sursa deschisa au accelerat raspandirea inteligentei artificiale in alte sectoare, de la securitatea nationala la asistenta in afaceri si medicina.

DeepMind, detinuta de Alphabet, si-a dezlantuit AI-ul intr-o varietate de probleme: miscarea jucatorilor de fotbal, restaurarea textelor antice si chiar modalitati de a controla fuziunea nucleara.

In 2020, DeepMind a declarat ca AI-ul sau AlphaFold ar putea prezice structura proteinelor, o problema de lunga durata care a ingreunat cercetarea. Acest lucru a fost considerat pe scara larga ca fiind una dintre primele dati in care s-a raspuns la o intrebare stiintifica reala cu ajutorul inteligentei artificiale. AlphaFold a fost folosit ulterior pentru a studia Covid-19, iar acum ajuta oamenii de stiinta sa studieze bolile neglijate.

Intre timp, consumatorii se pot astepta sa li se prezinte tot mai multe gadgeturi si servicii cu functii bazate pe inteligenta artificiala. Google si Amazon, in special, mizeaza pe faptul ca imbunatatirile in domeniul invatarii automate vor face ca asistentii lor virtuali si difuzoarele inteligente sa fie mai puternice. Amazon, de exemplu, dispune de dispozitive cu camere de luat vederi pentru a se uita la proprietarii lor si la lumea din jurul lor.

In ultimele doua decenii s-au facut multe progrese, dar mai sunt multe de facut. In ciuda avalansei de progrese recente in domeniul inteligentei artificiale si a pronosticurilor nebunesti cu privire la viitorul apropiat al acesteia, exista inca multe lucruri pe care masinile nu le pot face, cum ar fi intelegerea nuantelor limbajului, rationamentul de bun simt si invatarea de noi abilitati din doar unul sau doua exemple.

Programele de inteligenta artificiala vor trebui sa stapaneasca astfel de sarcini daca vor dori sa se apropie de inteligenta multifatetata, adaptabila si creativa a oamenilor, o idee cunoscuta sub numele de inteligenta generala artificiala care s-ar putea sa nu fie niciodata posibila. Un pionier al invatarii profunde, Geoff Hinton de la Google, sustine ca pentru a face progrese in aceasta mare provocare va fi necesara regandirea unora dintre bazele domeniului.

Inteligenta artificiala generativa si controversele sale

Exista un anumit tip de inteligenta artificiala care a ajuns in topul stirilor - in unele cazuri, chiar le si scrie. Inteligenta artificiala generativa (Generative AI) este un termen general pentru inteligenta artificiala care poate pune laolalta diverse fragmente (text, imagini, video, audio) pentru a crea ceva nou - sau mai bine zis, nou - cum ar fi arta, ilustratii, imagini, cod complet si functional si bucati de text care trec nu numai testul Turing, ci si examenele MBA.

Instrumente precum generatorul de text ChatGPT de la OpenAI si generatorul de text-imagine de la Stable Diffusion reusesc sa faca acest lucru absorbind cantitati incredibile de date, analizand modelele cu ajutorul retelelor neuronale si regurgitandu-le in moduri rationale.

Sistemul de limbaj natural din spatele ChatGPT a parcurs volume uriase de continut de pe internet, precum si un numar imens de carti, permitandu-i sa raspunda la intrebari, sa scrie continut in functie de solicitari si, in cazul CNET, sa scrie articole explicative pentru site-uri web care sa corespunda termenilor de cautare. (Pentru a fi clar, acest articol nu a fost scris de ChatGPT, desi includerea textului generat de sistemul de limbaj natural devine rapid un cliseu de scriere a inteligentei artificiale).

In timp ce investitorii saliveaza, scriitorii, artistii plastici si alti creatori sunt, fireste, ingrijorati: Chatbots sunt (sau cel putin par a fi) ieftine, iar oamenii au nevoie de un venit decent. De ce sa platesti un ilustrator pentru o imagine, cand il poti indemna pe Dall-E sa faca acelasi lucru gratuit?

Adio Googling, bun venit ChatGPTing?

Creatorii de continut nu sunt singurii ingrijorati. Google isi intensifica discret eforturile de inteligenta artificiala ca raspuns la realizarile OpenAI, iar gigantul in domeniul cautarilor ar trebui sa fie ingrijorat de ceea ce se intampla cu obiceiurile de cautare ale oamenilor atunci cand chatbots pot raspunde la intrebari in locul nostru.

Cu toate acestea, la orizont se intrevad provocari. Modelele de inteligenta artificiala au nevoie de din ce in ce mai multe date pentru a se imbunatati, dar OpenAI a folosit deja sursele usoare; gasirea de noi gramezi de text scris pe care sa le foloseasca nu va fi usoara sau gratuita.

De asemenea, se intrevad provocari juridice: OpenAI isi antreneaza sistemul pe texte si imagini care pot fi protejate prin drepturi de autor, poate chiar create de aceleasi persoane ale caror locuri de munca sunt amenintate de aceasta tehnologie. Si, pe masura ce tot mai mult continut online este creat cu ajutorul inteligentei artificiale, se creeaza o bucla de feedback in care modelele de formare a datelor online nu vor fi create de oameni, ci de masini.

Lasand la o parte datele, exista o problema fundamentala cu astfel de modele lingvistice: acestea scot un text care se citeste destul de bine, dar nu este neaparat precis. Oricat de inteligente ar fi aceste modele, ele nu stiu ce spun si nici nu au vreo notiune de adevar - acest lucru este usor de uitat in graba nebuna de a folosi astfel de instrumente pentru noi afaceri sau pentru a crea continut. Cuvintele nu trebuie doar sa sune bine, ci si sa transmita un inteles.

Provocarile (si viitorul) inteligentei artificiale

Exista la fel de multi critici ai inteligentei artificiale pe cat de multi sustinatori - ceea ce este o veste buna, avand in vedere entuziasmul din jurul acestui set de tehnologii. Criticile la adresa AI ating aspecte atat de disparate precum sustenabilitatea, etica, prejudecatile, dezinformarea si chiar drepturile de autor, unii sustinand ca tehnologia nu este atat de capabila pe cat crede majoritatea, iar altii prezicand ca va fi sfarsitul umanitatii asa cum o cunoastem.

Sunt multe de luat in considerare.

Pentru inceput, invatarea profunda necesita, in mod inerent, cantitati uriase de date si, desi inovatiile din domeniul cipurilor inseamna ca putem face acest lucru mai repede si mai eficient ca niciodata, nu exista nicio indoiala ca cercetarea in domeniul IA consuma energie.

- Un start-up a estimat ca, pentru a invata un sistem sa rezolve un cub Rubik folosind o mana robotica, OpenAI a consumat 2,8 gigawati-ora de energie electrica - cat ar putea produce trei centrale nucleare intr-o ora.

- Alte estimari sugereaza ca antrenarea unui model de inteligenta artificiala emite la fel de mult dioxid de carbon ca si cinci masini americane fabricate si conduse pe durata medie de viata a acestora.

Exista tehnici de reducere a impactului: Cercetatorii dezvolta tehnici de instruire mai eficiente, modelele pot fi fragmentate astfel incat sa fie rulate doar sectiunile necesare, iar centrele de date si laboratoarele se orienteaza catre o energie mai curata.

Inteligenta artificiala are, de asemenea, un rol de jucat in imbunatatirea eficientei in alte industrii si in alte moduri de a contribui la solutionarea crizei climatice. Dar cresterea acuratetei inteligentei artificiale inseamna, in general, ca modelele mai complicate trebuie sa analizeze mai multe date - modelul GPT2 al OpenAI ar fi avut 1,5 miliarde de ponderi pentru a evalua datele, in timp ce GPT3 a avut 175 de miliarde - ceea ce sugereaza ca durabilitatea inteligentei artificiale ar putea sa se inrautateasca inainte de a se imbunatati.

Aspirarea tuturor datelor necesare pentru a construi aceste modele creeaza provocari suplimentare, dincolo de disponibilitatea tot mai redusa a datelor noi mentionate mai sus.

Partizanatul ramane o problema de baza: seturile de date reflecta lumea din jurul nostru, ceea ce inseamna ca modelele absorb rasismul, sexismul si alte presupuneri culturale ale noastre. Acest lucru cauzeaza o serie de probleme grave: Inteligenta artificiala antrenata sa detecteze cancerul de piele are rezultate mai bune pe pielea alba; software-ul conceput pentru a prezice recidiva considera, in mod inerent, ca persoanele de culoare au o probabilitate mai mare de a recidiva; iar software-ul de recunoastere faciala cu inteligenta artificiala defectuoasa a identificat deja in mod incorect barbati de culoare, ceea ce a dus la arestarea acestora.

Si, uneori, inteligenta artificiala pur si simplu nu functioneaza: Un instrument de predictie a infractiunilor violente pentru politie a fost extrem de imprecis din cauza unei erori de codare.

Din nou, sunt posibile atenuari. Seturi de date mai cuprinzatoare ar putea ajuta la combaterea prejudecatilor la sursa, in timp ce obligarea companiilor de tehnologie sa explice procesul decizional algoritmic ar putea adauga un nivel de responsabilitate. Diversificarea industriei dincolo de barbatii albi nu ar strica nici ea. Dar cele mai serioase provocari ar putea necesita reglementarea - si poate interzicerea - utilizarii procesului decizional al IA in situatiile cu cel mai mare risc de daune grave pentru oameni.

Acestea sunt cateva exemple de rezultate nedorite dar oamenii folosesc deja inteligenta artificiala in scopuri nefaste, cum ar fi crearea de deepfakes si raspandirea dezinformarii.

In timp ce videoclipurile si imaginile editate sau generate de AI au cazuri de utilizare intrigante - cum ar fi inlocuirea actorilor vocali dupa ce acestia parasesc un spectacol sau decedeaza -, AI-ul generativ a fost, de asemenea, utilizat pentru a realiza deepfake-uri pornografice, adaugand fete celebre unor actori adulti sau folosit pentru a defaima persoane obisnuite.

Tehnologia AI a fost folosita pentru a inunda web-ul cu dezinformare, desi verificatorii de fapte au apelat la aceasta tehnologie pentru a riposta.

Pe masura ce sistemele de inteligenta artificiala devin tot mai puternice, acestea vor atrage, pe buna dreptate, mai multa atentie. Utilizarea guvernamentala a software-ului in domenii precum justitia penala este adesea defectuoasa sau secreta, iar corporatii precum Meta au inceput sa se confrunte cu aspectele negative ale propriilor algoritmi de modelare a vietii.

O inteligenta artificiala mai puternica are potentialul de a crea probleme si mai grave, de exemplu, prin perpetuarea prejudecatilor si stereotipurilor istorice impotriva femeilor sau a persoanelor de culoare. Grupuri ale societatii civile si chiar industria tehnologica insasi exploreaza acum reguli si orientari privind siguranta si etica IA.

Dar agitatia din jurul modelelor generative sugereaza ca inca nu ne-am invatat lectia cand vine vorba de IA. Trebuie sa ne calmam, sa intelegem cum functioneaza si cand nu functioneaza, iar apoi sa implementam acest instrument intr-un mod atent si ponderat, atenuand preocuparile pe masura ce sunt ridicate.

Inteligenta artificiala are un potential real de a ne imbunatati - si chiar de a ne prelungi - viata, dar pentru a profita cu adevarat de avantajele oferite de masinile din ce in ce mai inteligente, va trebui sa devenim mai inteligenti in ceea ce priveste masinile.

Termeni folositi in AI

Sunt termeni de care te-ai lovit sau cel putin te vei lovi de acum inainte. Asadar, iata termenii cei mai comuni care fac referire la tehnologia AI:

- Inteligenta artificiala: Dezvoltarea de computere capabile sa indeplineasca sarcini care necesita in mod obisnuit inteligenta umana.

- Invatare automata: Folosirea datelor exemplificative sau a experientei pentru a perfectiona modul in care computerele fac predictii sau indeplinesc o sarcina.

- Invatare profunda: O tehnica de invatare automata in care datele sunt filtrate prin intermediul unor retele de matematica autoreglabile, inspirate in mare masura de neuronii din creier.

- Invatare supravegheata: Prezentarea de date de exemplu etichetate de software, cum ar fi fotografii, pentru a invata un computer ce sa faca.

- Invatare nesupravegheata: Invatarea fara exemple adnotate, doar din experienta datelor sau a lumii - triviala pentru oameni, dar in general nepractica pentru masini. Totusi.

- Invatarea prin intarire: Software care experimenteaza diferite actiuni pentru a afla cum sa maximizeze o recompensa virtuala, cum ar fi obtinerea de puncte intr-un joc.

- Inteligenta generala artificiala: Software inca inexistent care prezinta o capacitate similara celei umane de a se adapta la diferite medii si sarcini si de a transfera cunostinte intre ele.

🙏 Ti-am fost de ajutor? Atunci poti ajuta si tu distribuind articolul (cu un click pe iconita de jos). Multumesc!